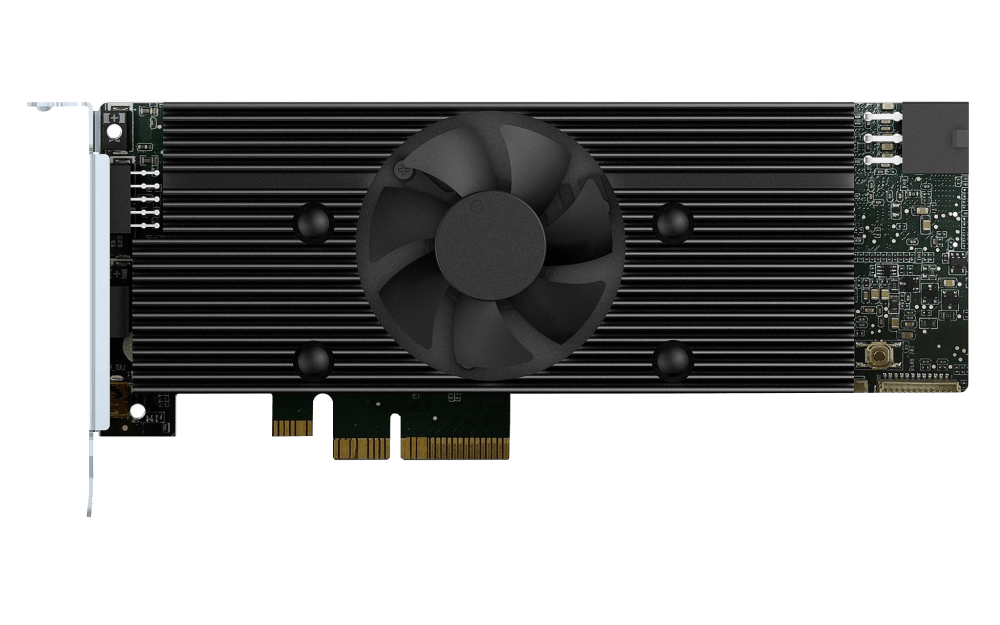

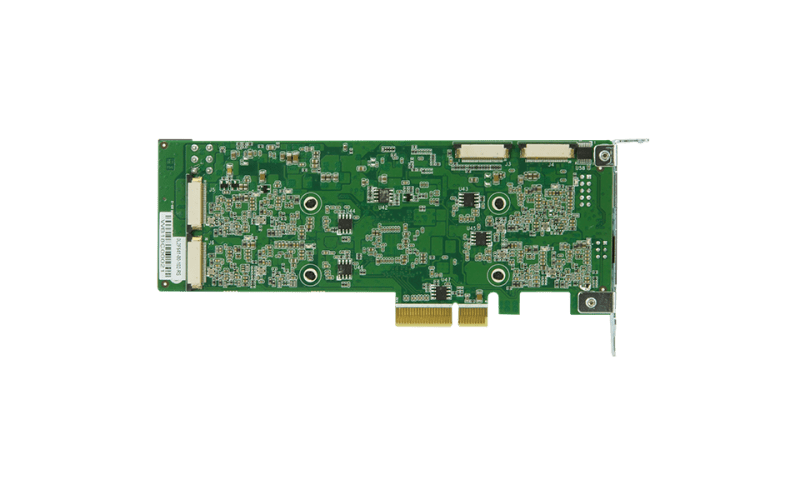

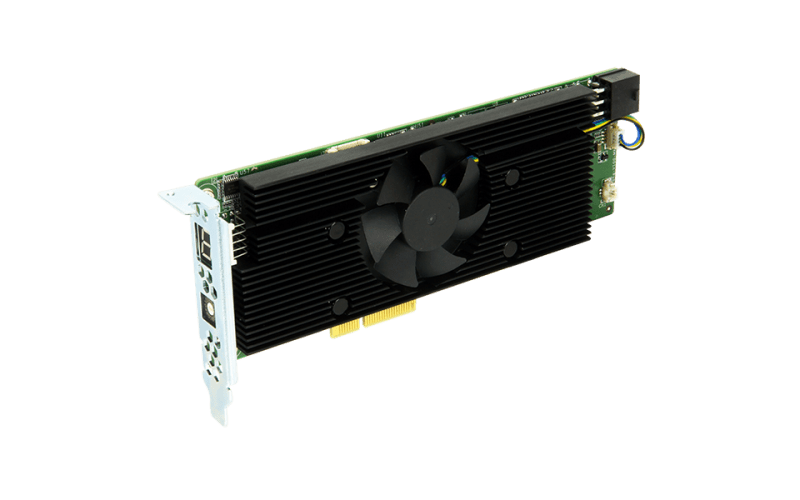

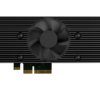

Karta Mustang-V100-RX8-R10

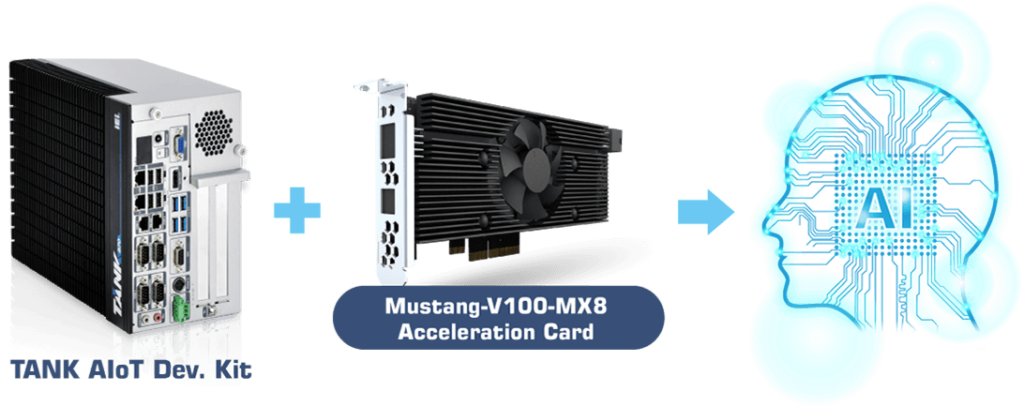

Serwer QNAP NAS ewoluuje aby umożliwiać realizację coraz szerszej gamy zastosowań (m.in. monitoringu, wirtualizacji oraz sztucznej inteligencji), co oznacza, że użytkownik nie tylko potrzebuje coraz więcej miejsca do magazynowania na urządzeniu NAS, ale także większej mocy NAS w celu optymalizacji zaplanowanej pracy. Model Mustang-V100 to oparta na PCIe karta akceleratora, korzystająca z Intel® Movidius™ VPU, która napędza wymagające zadania w zakresie nowoczesnego widzenia komputerowego i zastosowań sztucznej inteligencji. Może być instalowana w komputerze lub na kompatybilnym serwerze QNAP NAS, zwiększając ich wydajność, dzięki czemu stanowi idealny wybór w przypadku zadań w zakresie inferencji głębokiego uczenia AI. >> Czym różni się model Mustang-F100 od modelu Mustang-V100.

Uzyskaj akcelerację głębokiego uczenia na serwerze/komputerze z architekturą Intel

Model Mustang-V100 można zainstalować na komputerze/na stacji roboczej z systemem Linux® (Ubuntu®), aby uzyskać akcelerację obliczeniową, zapewniającą optymalną wydajność takich zastosowań, jak inferencja głębokiego uczenia, strumieniowanie wideo i centrum danych. Stanowiąc idealne rozwiązanie do akceleracji dla inferencji AI w czasie rzeczywistym, model Mustang-V100 może także współdziałać z zestawem narzędzi Intel® OpenVINO™, optymalizując liczbę zadań w zakresie inferencji w przypadku klasyfikacji obrazów i widzenia komputerowego.

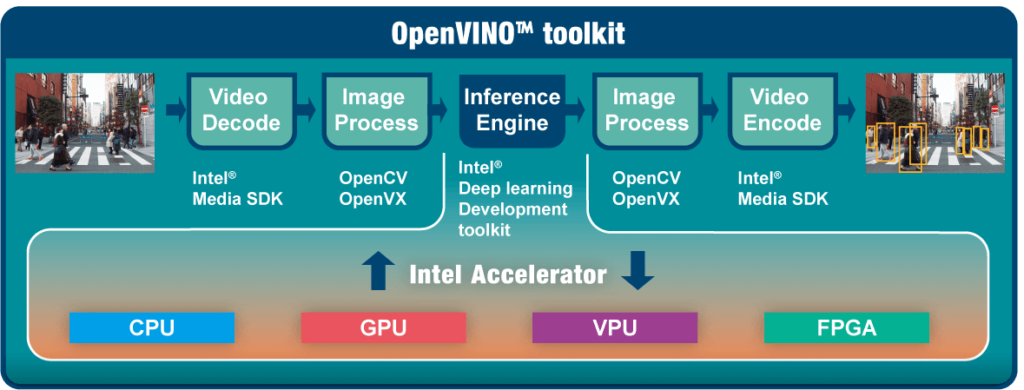

Zestaw narzędzi OpenVINO™

Zestaw narzędzi OpenVINO™ jest oparty na sieci CNN (ang. Convolutional Neural Networks) i pozwala zwiększyć liczbę zadań na całym sprzęcie Intel®, maksymalizując wydajność.

Zestaw pozwala na optymalizację modelu głębokiego uczenia z wcześniejszych szkoleń, np. konwertując format Caffe, MXNET, Tensorflow w plik binarny IR, a następnie może uruchomić silnik inferencji niejednorodnie na całym sprzęcie Intel®, np. na procesorze, karcie graficznej, Intel® Movidius™ Neural Compute Stick i FPGA.

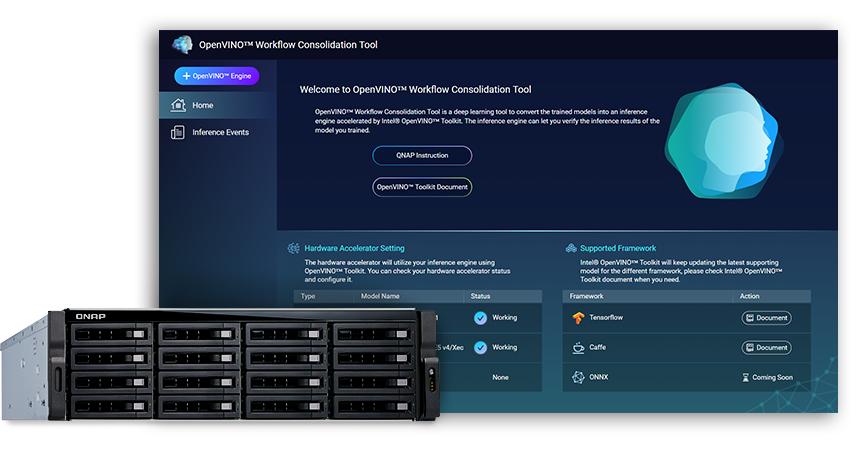

QNAP NAS jako serwer inferencji

Zestaw narzędzi OpenVINO™ umożliwia dystrybucję obciążenia pracą na osprzęt Intel® (w tym akceleratory), zwiększając maksymalnie wydajność. W przypadku korzystania z narzędzia OpenVINO™ Workflow Consolidation Tool firmy QNAP, urządzenie QNAP NAS oparte na architekturze Intel® służy jako idealny serwer inferencji, pozwalające organizacjom na szybkie tworzenie systemu inferencji. Zestaw narzędzi OpenVINO™ zawiera narzędzie do optymalizacji modelu i silnik inferencji, dzięki czemu jest łatwy w obsłudze i zapewnia elastyczność umożliwiającą uzyskanie wysokiej wydajności, niewielkie opóźnienia widzenia komputerowego, ulepszając inferencje głębokiego uczenia. Projektanci sztucznej inteligencji (AI) mogą wdrażać w urządzeniach QNAP NAS modele szkoleniowe w celu uzyskania inferencji, i instalować modele Mustang-V100, aby uzyskać optymalną wydajność potrzebną do aktywowania inferencji.

Nie ma jeszcze żadnych opinii.